- 首页

- Ollama

本文由AI翻译

Ollama

Ollama 是一款开源软件,可以运行流行的 AI 模型,例如 Llama 3.2 或 Gemma 2。

这是一个关于为 ONLYOFFICE 文档安装和配置 Ollama 的分步指南。

连接和配置 Ollama

- (可选) 如果您习惯在 macOS 和 Linux 上使用 Homebrew 管理软件包,请安装:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)" -

要安装 Ollama,请运行以下命令:

curl -fsSL https://ollama.com/install.sh | sh对于 Homebrew,请运行以下命令:

brew install ollama安装完成后,Ollama 会在您的机器上提供用于服务、列出、检查和运行模型的命令。

-

按以下步骤配置 Ollama:

-

在终端中运行以下命令以启动本地 AI 服务器:

export OLLAMA_ORIGINS=http://*,https://*,onlyoffice://* -

立即启动 Ollama 并在登录时重新启动:

brew services start ollama -

如果不需要后台服务,请运行以下命令:

ollama serve

-

在终端中运行以下命令以启动本地 AI 服务器:

-

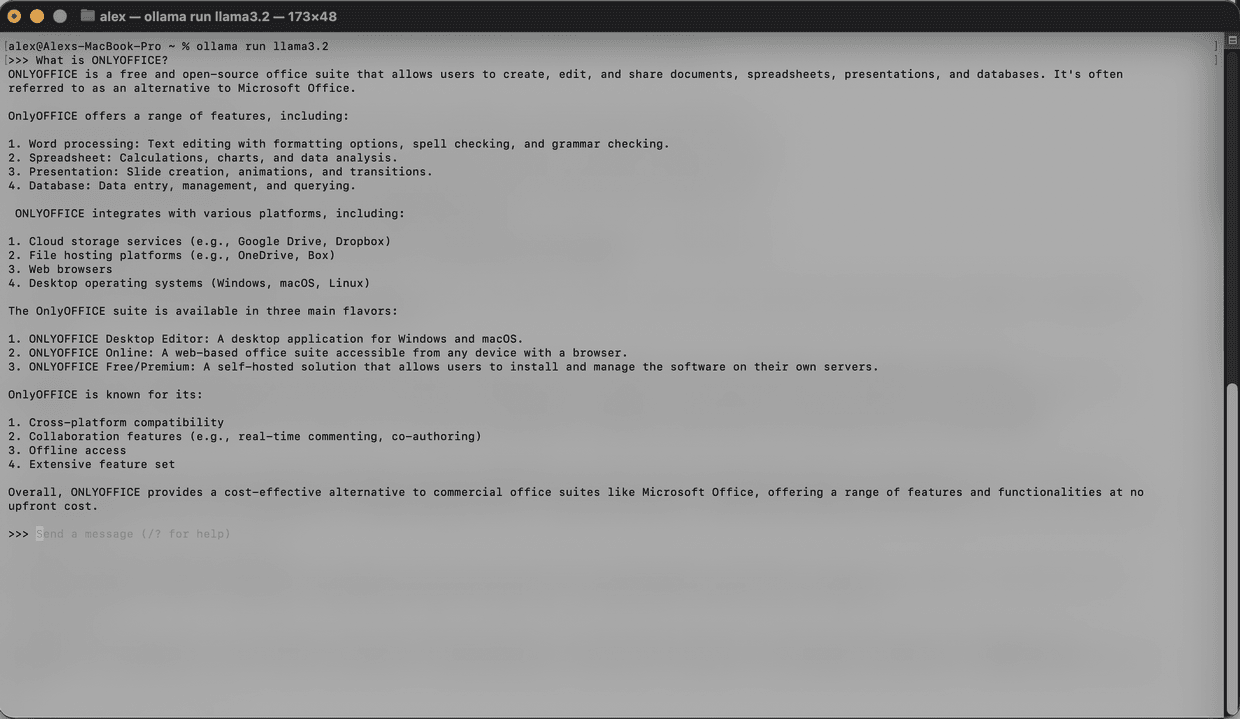

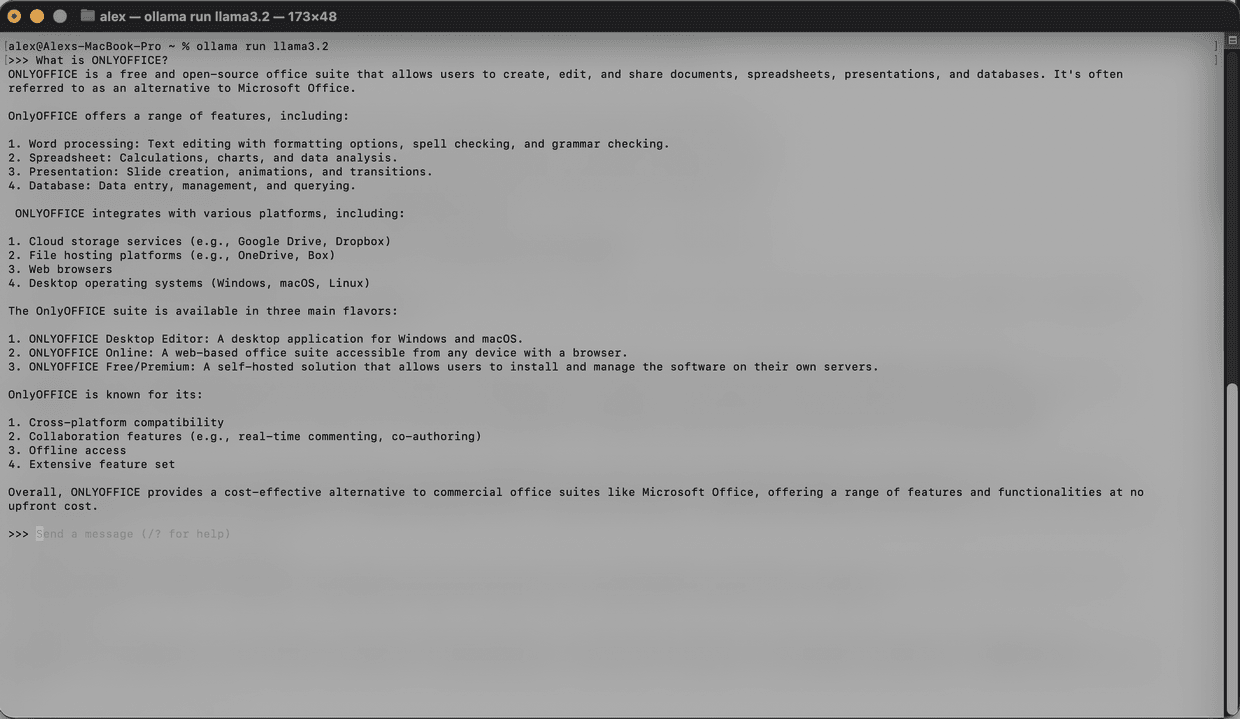

在另一个终端窗口中下载您想使用的模型。例如,要安装并运行 Llama 3.2:

ollama run llama3.2

模型将被下载并在本地启动。安装的模型数量没有限制。有关可用模型的列表,请参阅Ollama 官方文档。

在安装之前,请确保您的机器有足够的内存和磁盘空间来存储模型。

- 请参阅本指南以获取 AI 插件的一般配置。

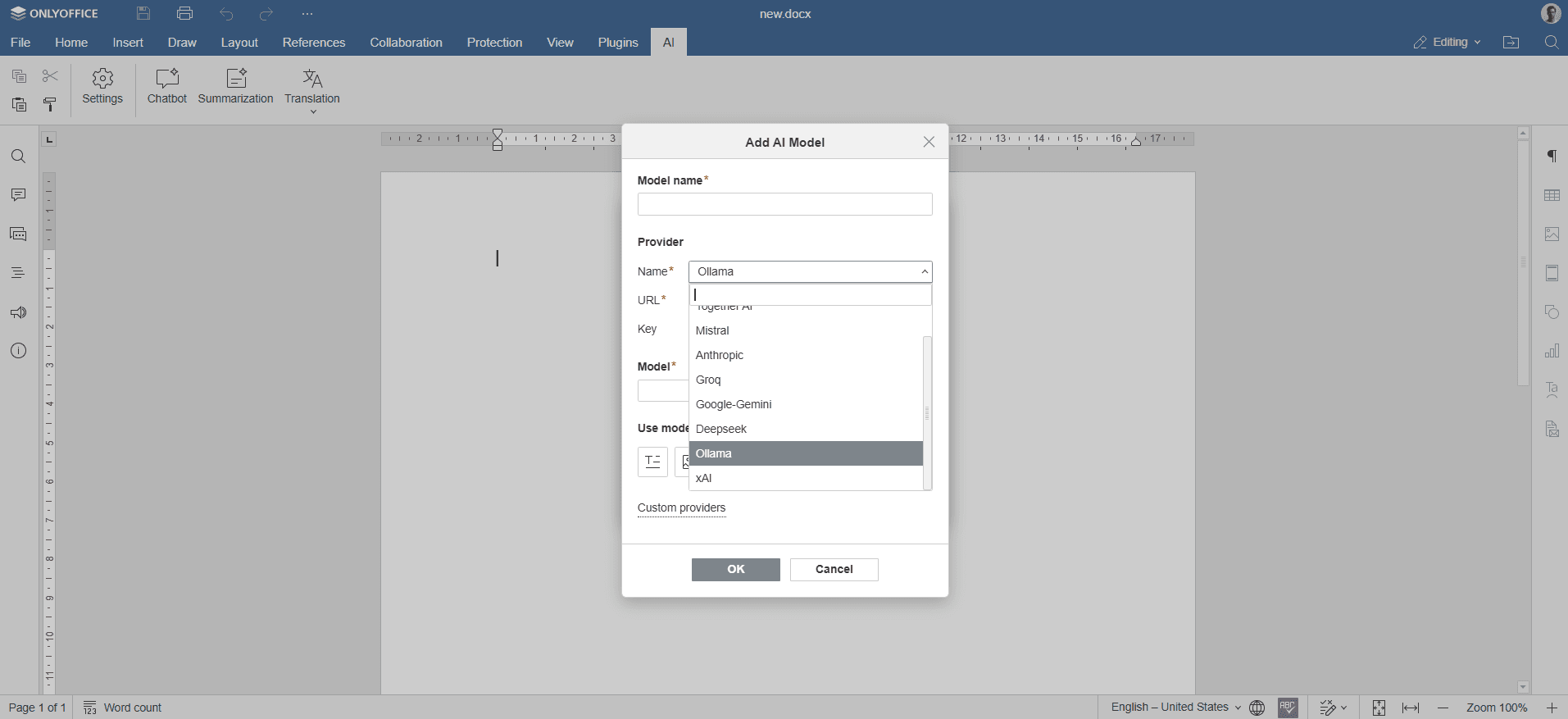

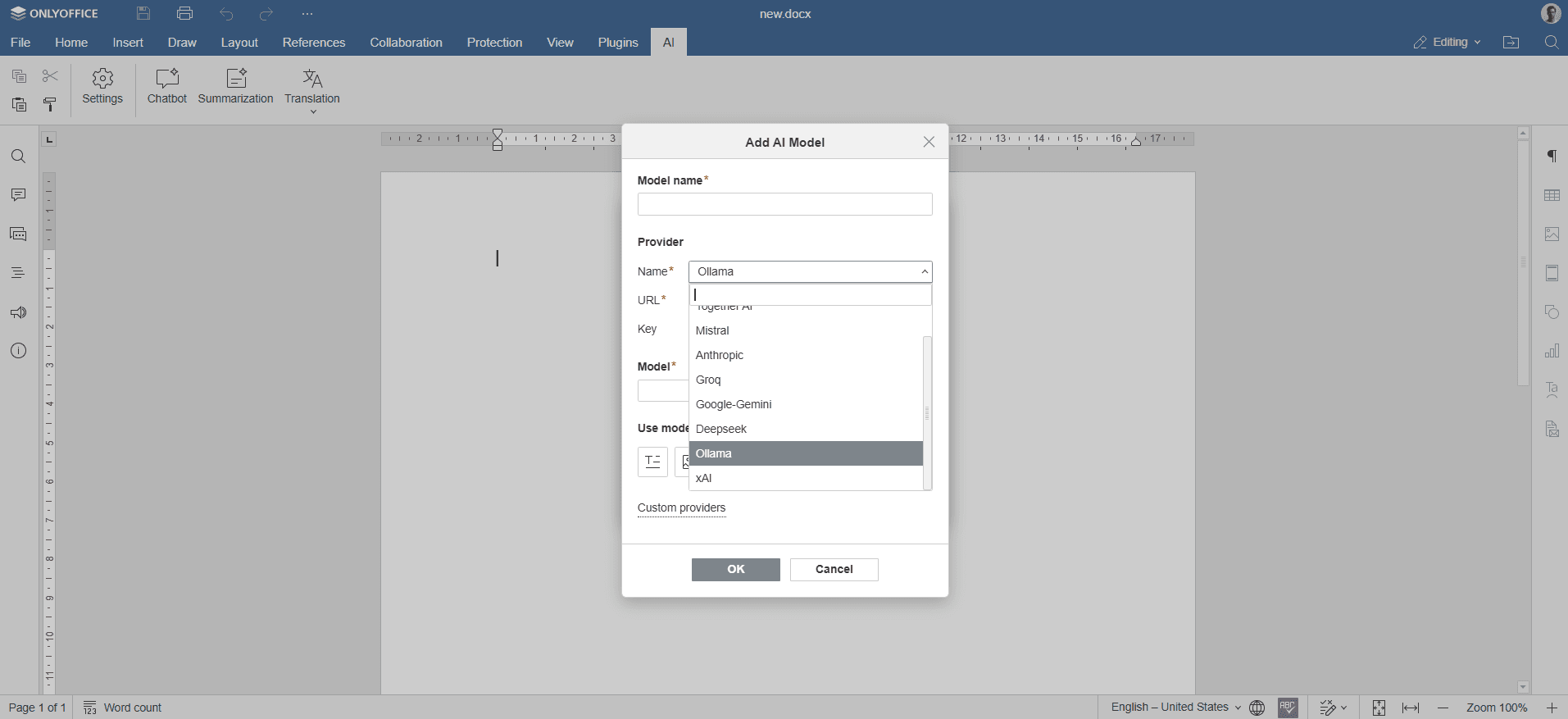

- 插件安装后,添加 AI 模型。进入 AI 选项卡,打开 设置。

- 在窗口左下角选择 编辑 AI 模型,然后点击 添加。

-

在出现的窗口中,选择 Ollama 作为提供商,并将 URL 设置为

http://localhost:11434。

- 从下拉列表中选择已安装的模型(例如,

llama3.2:latest),然后确认。 - 在图标行中,选择用于文本、图像、嵌入、音频处理、内容审核、实时任务、编码帮助和视觉分析的模型。

- 点击 确定 并关闭窗口。该模型将出现在 AI 模型列表中的可用模型列表中。

- 为 AI 分配不同的任务。从下拉列表中选择将执行这些任务的已安装 AI 模型。

- 通过 AI 选项卡或选择文本并右键单击以打开上下文菜单来访问 AI 功能。

文章: 标签:

浏览所有标签